解决BERT模型在GPU上运行时利用率低的问题

人工智能

2024-04-11 17:30

700

联系人:

联系方式:

摘要:在使用BERT模型进行自然语言处理任务时,我们可能会遇到GPU利用率低的问题。本文将探讨可能的原因并提供一些解决方案,以帮助您提高GPU的利用率。

一、问题描述

当我们在训练或推理过程中使用BERT模型时,有时会发现GPU的使用率一直为0%。这意味着GPU的计算资源没有得到充分利用,可能会导致训练速度慢或者无法完成大规模的数据处理任务。

二、可能的原因

- 数据批次大小(batch size)过小:如果批次大小设置得过小,那么每个批次中的样本数量就会很少,导致GPU的计算资源没有得到充分利用。

- 序列长度过长:BERT模型在处理长序列时需要进行大量的计算,这可能会导致GPU利用率降低。

- 代码优化不足:如果代码中存在冗余操作或者不必要的计算,也会导致GPU利用率降低。

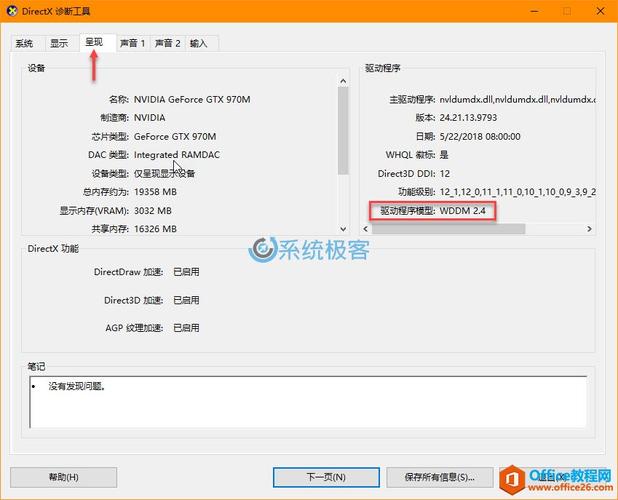

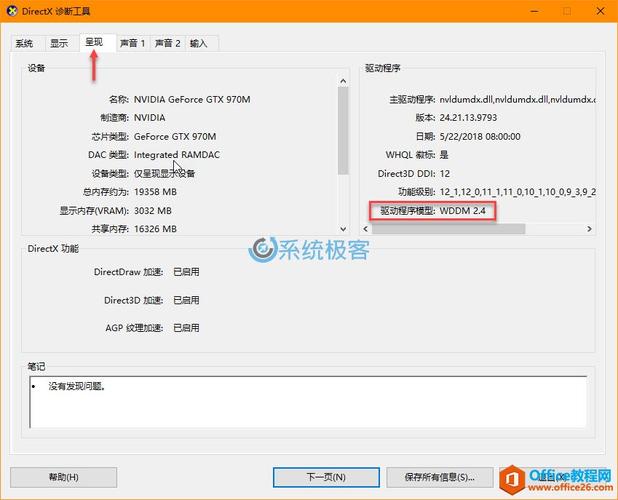

- GPU驱动版本过低:过时的GPU驱动可能导致兼容性问题,从而影响GPU的性能和利用率。

- CUDA版本不匹配:CUDA是NVIDIA推出的并行计算平台和编程模型,如果CUDA版本与您的深度学习框架不兼容,也可能导致GPU利用率低。

- 内存不足:如果GPU的显存不足以容纳大型模型和数据,可能会导致利用率降低。

- 其他进程占用GPU资源:如果有其他进程正在使用GPU资源,那么BERT模型的运行可能会受到影响。

三、解决方案

- 调整数据批次大小:根据您的硬件配置和任务需求,适当增加批次大小可以提高GPU利用率。但请注意,过大的批次大小可能会导致内存溢出等问题。

- 截断长序列:对于过长的序列,可以考虑进行截断操作,以减少计算量。也可以尝试使用更高效的注意力机制变体,如稀疏注意力等。

- 代码优化:检查您的代码是否存在冗余操作或不必要计算,并进行相应的优化。例如,可以使用混合精度训练来减少计算量和显存占用。

- 更新GPU驱动:确保您的GPU驱动是最新的,以便获得更好的性能和兼容性。

- 检查CUDA版本:确保您的CUDA版本与深度学习框架兼容。如果不确定,可以尝试安装最新版本的CUDA。

- 扩展显存:如果可能的话,考虑升级到具有更大显存的GPU型号。还可以尝试使用模型压缩技术来减小模型大小。

- 检查其他进程:使用nvidia-smi命令查看当前正在运行的GPU进程,并关闭不必要的进程以提高BERT模型的GPU利用率。

四、总结

通过以上方法,您可以有效地解决BERT模型在GPU上运行时利用率低的问题。然而,需要注意的是,这些解决方案并非万能的,可能需要根据实际情况进行调整和优化。在实际应用中,建议结合多种方法来提高GPU利用率,以实现更高的性能和效率。

摘要:在使用BERT模型进行自然语言处理任务时,我们可能会遇到GPU利用率低的问题。本文将探讨可能的原因并提供一些解决方案,以帮助您提高GPU的利用率。

一、问题描述

当我们在训练或推理过程中使用BERT模型时,有时会发现GPU的使用率一直为0%。这意味着GPU的计算资源没有得到充分利用,可能会导致训练速度慢或者无法完成大规模的数据处理任务。

二、可能的原因

- 数据批次大小(batch size)过小:如果批次大小设置得过小,那么每个批次中的样本数量就会很少,导致GPU的计算资源没有得到充分利用。

- 序列长度过长:BERT模型在处理长序列时需要进行大量的计算,这可能会导致GPU利用率降低。

- 代码优化不足:如果代码中存在冗余操作或者不必要的计算,也会导致GPU利用率降低。

- GPU驱动版本过低:过时的GPU驱动可能导致兼容性问题,从而影响GPU的性能和利用率。

- CUDA版本不匹配:CUDA是NVIDIA推出的并行计算平台和编程模型,如果CUDA版本与您的深度学习框架不兼容,也可能导致GPU利用率低。

- 内存不足:如果GPU的显存不足以容纳大型模型和数据,可能会导致利用率降低。

- 其他进程占用GPU资源:如果有其他进程正在使用GPU资源,那么BERT模型的运行可能会受到影响。

三、解决方案

- 调整数据批次大小:根据您的硬件配置和任务需求,适当增加批次大小可以提高GPU利用率。但请注意,过大的批次大小可能会导致内存溢出等问题。

- 截断长序列:对于过长的序列,可以考虑进行截断操作,以减少计算量。也可以尝试使用更高效的注意力机制变体,如稀疏注意力等。

- 代码优化:检查您的代码是否存在冗余操作或不必要计算,并进行相应的优化。例如,可以使用混合精度训练来减少计算量和显存占用。

- 更新GPU驱动:确保您的GPU驱动是最新的,以便获得更好的性能和兼容性。

- 检查CUDA版本:确保您的CUDA版本与深度学习框架兼容。如果不确定,可以尝试安装最新版本的CUDA。

- 扩展显存:如果可能的话,考虑升级到具有更大显存的GPU型号。还可以尝试使用模型压缩技术来减小模型大小。

- 检查其他进程:使用nvidia-smi命令查看当前正在运行的GPU进程,并关闭不必要的进程以提高BERT模型的GPU利用率。

四、总结

通过以上方法,您可以有效地解决BERT模型在GPU上运行时利用率低的问题。然而,需要注意的是,这些解决方案并非万能的,可能需要根据实际情况进行调整和优化。在实际应用中,建议结合多种方法来提高GPU利用率,以实现更高的性能和效率。